반응형

검증집합과 교차검증을 이용한 모델 선택 알고리즘

검증집합을 이용한 모델 선택

- 모델집합의 여러 모델을 독립적으로 학습시킨 후 그중 가장 좋은 모델을 선택해야 한다. 이때 모델을 비교하는 데 사용할 별도의 데이터집합을 검증집합 이라고 한다.

- 훈련집합과 테스트 집합과 다른 별도의 검증집합을 가진 상황 (데이터 양 많음)

교차검증

- 비용 문제로 데이터의 양은 대부분 부족하다. 이러한 상황에서는 검증집합을 마련하기 힘든데, 교차검증을 이용하면 효과적이다.

- 비용 문제로 별도의 검증집합이 없는 상황에 유용한 모델 선택 기법 (데이터 양 적음)

- 훈련 집합을 등분하여, 학습과 평가 과정을 여러 번 반복한 후 평균 사용

10겹 교차 검증의 예

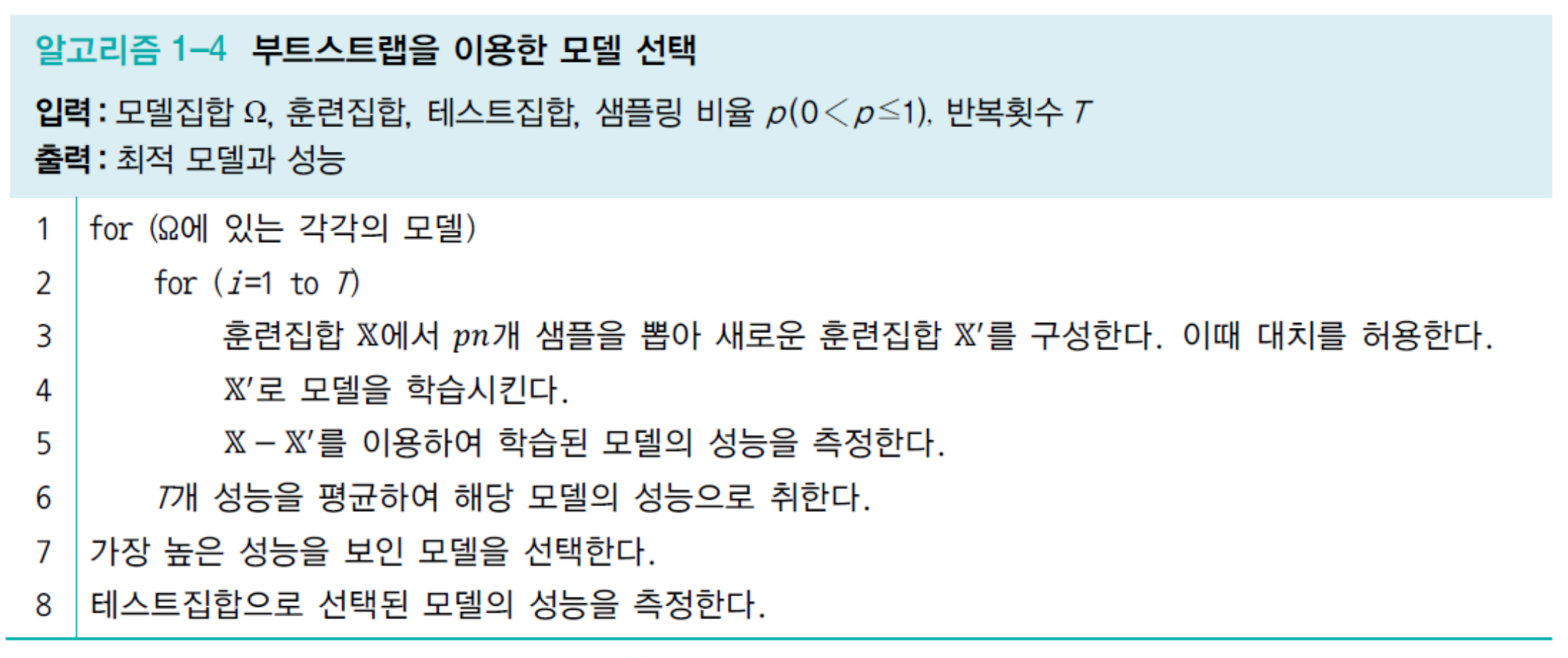

부트스트랩

- 임의의 복원 추출 샘플링 반복한다. 이때 대치를 허용하여 같은 샘플이 여러 번 뽑힐 수 있다.

- 데이터 분포가 불균형일 때 적용

- 복원 추출 샘플링이다. 특정 개수만큼 데이터를 뽑아서 학습을 하고, 다시 집어넣는다.

- 10000개의 데이터와 100개의 데이터에서 똑같이 데이터를 뽑아야 한다면 100개의 데이터는 양이 적으므로 반복해서 뽑아야 한다.

- 데이터가 적은 쪽에 맞춰서도 문제를 해결할 수도 있다. 하지만 데이터가 적으면 문제가 많이 발생하니까 그런 경우는 적다.

모델 선택의 한계와 현실적인 해결책

- 위의 검증집합, 교차검증, 부트스트랩에서 가장 중요한 입력은 모델 집합Ω이다.

- 모델집합Ω에서 가장 좋은 것을 찾아내는 것이 목표이기 때문

- 현실에서는 학습 모델들이 아주 다양함 → 가능한 모델은 수없이 많음

- 현실에서는 경험을 통해 큰 틀 (가설)을 선택하고 그 틀 안에서 모델 선택 알고리즘으로 세부 모델을 선택하는 전략을 사용

- ex) 신경망 중 MLP를 사용하기로 결정 후 은닉층 개수나 활성함수는 무엇을 사용할지 등을 결정하는데 검증집합, 교차검증, 부트스트랩을 사용하는 식

- 이처럼 데이터 생성 과정에 대한 지식이 없는 상황에서 경험적인 접근방식을 사용하는 상황을 다음과 같이 묘사함.

- 현재 기계학습은 용량이 충분히 큰 모델을 선택한 후, 선택한 모델이 정상을 벗어나지 않도록 여러 규제 기법을 적용

규제

데이터 확대

- 데이터를 더 많이 수집하면 일반화 능력이 향상됨.

- 데이터 수집은 많은 비용이 듦 → 실측자료를 사람이 일일이 라벨링 해야 하기 때문

- 인위적으로 데이터 확대

- 훈련집합에 있는 샘플을 변형함 (ex. 약간 회전 rotation 또는 왜곡 warping (원 데이터의 부류 소속 등의 고유 특성 변하지 않게 주의)

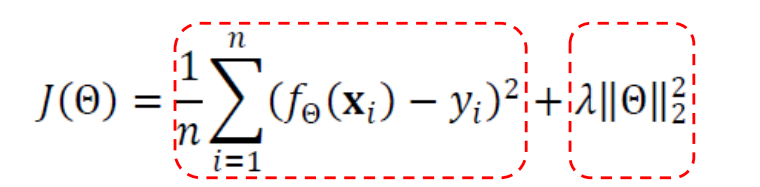

가중치 감쇠

- (a)의 곡선은 굴곡이 매우 심하다. 다시 말해 극점에서 곡률이 매우 크다. 아래는 이 곡선의 방정식인데, 매개변수, 즉 계수의 값이 무척 크다.

- 가중치 감쇠라는 규제 기법은 가중치를 작게 유지함으로써 일반화 능력을 향상한다.

- 개선된 목적함수를 이용하여 가중치를 작게 조절한다.

- 추가된 두 번째 항은 규제 항으로서 가중치 크기를 작게 조절해준다.

- 𝜆는 주어진 가중치의 감쇠 선호 정도를 제어한다.

- 𝜆=0: 감쇠 없음

- 작은 λ 값은 w 를 적게 제약하는 반면, 큰 값은 w 를 많이 제약

- 가중치 매개변수는 우리가 학습시키고 싶은 대상이다.

- 모델을 만든 뒤 모델(가설)이 가지고 있는 매개변수(가중치)가 최적화되도록, 성능이 좋아지도록, 에러를 최소화시킬 수 있도록 하는 것이 훈련의 과정이다.

- 가중치를 감소시킨다는 것은 모델의 용량이 낮춘다는 것이며 이는 과잉적합 확률을 줄여버린다.

- 즉, 매개변수 값들이 다 발현이 되면 과잉적합이 되므로 이걸 줄여보자라고 하는 게 가중치 감쇠이다. 가중치 감쇠는 목적함수를 개선하며 이루어진다. 목적함수가 최소화되는 방향으로 매개변수가 설정되므로 매개변수는 목적함수에 의해서 결정된다. 그러므로 목적함수를 개선을 해서 이 가중치들이 작아지게끔 조절하자는 것이다.

- 1차보다 2차 다항식이 더 용량이 크다. 예를 들어 w2x^2 + w1x + b에서 극단적인 경우 파라미터가 다 발현되면 자유도가 높아서 용량이 높지만, 발현 못하게끔 해버리면 w2 = 0을 해버리면 가중치를 다 발현되지 못하게 되어 용량을 낮출 수 있다는 것이다. 대표적인 규제 방법 중 하나이다.

참고

반응형

'Artificial intelligence' 카테고리의 다른 글

| [AI] 다층 퍼셉트론 - 특징공간 변환 (XOR 분류 테스트) (0) | 2021.10.27 |

|---|---|

| [AI] 단층 퍼셉트론 (Single-layer Perceptron) (0) | 2021.09.23 |

| [AI] 과소적합(underfitting)과 과잉적합(overfitting) / 바이어스(bias)와 분산(variance) (0) | 2021.09.10 |

| [AI] 기계 학습 유형 (0) | 2021.09.10 |

| [AI] Convex Optimization (볼록 최적화) / Convex, Non-Convex (0) | 2021.09.08 |